Bilderverständnis im Gebäudeschaden: Status und Herausforderungen

This post is also available in English. Click here to download.

Der Regulierungsprozess steht im Zentrum der Beziehung zwischen dem Versicherungsnehmer und der Versicherung – ein Prozess, der auf einem intensiven Datenaustausch zwischen beiden Parteien basiert.

Die Art dieser Daten kann sehr vielfältig sein und enthält normalerweise strukturierte Informationen, die zum Beispiel über Webformulare oder telefonische Kommunikation übertragen werden. Aber auch unstrukturierte oder nur wenig strukturierte Daten in Form von Freitexten, Reparaturrechnungen, Angeboten oder Fotos von beschädigten Objekten gehören dazu. Letztere sind besonders wertvoll, da sie bereits sehr früh im Schadenprozess auftauchen.

Fotos sind reich an Informationen und können vom Versicherungsnehmer ohne besondere Ausstattung oder Fähigkeiten erstellt werden. Um den Regulierungsprozess qualitativ hochwertig zu automatisieren ist es daher wichtig, Computern das Verständnis von Fotos und die automatische Extraktion von relevanten Informationen zum Schaden beizubringen.

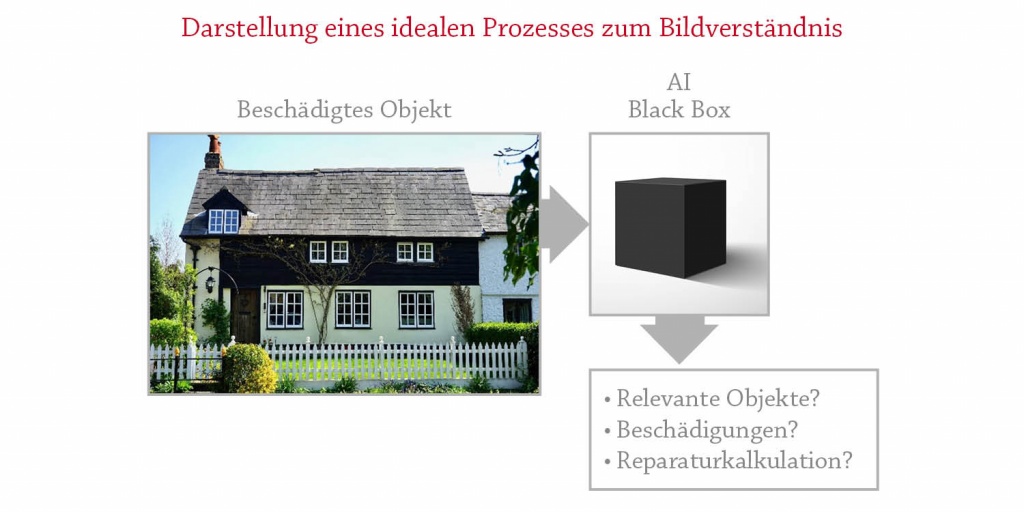

Ein ideales Foto-Analyse-System (siehe nachfolgendes Bild) würde von einem Foto eines vermutlich beschädigten Objektes folgende Informationen wiedergeben:

- Eine Liste der versicherungsrelevanten Objekte in dem Bild

- Zustand jedes einzelnen Objektes (intakt, beschädigt, alt, etc.)

- Kosten in Verbindung mit der Reparatur oder dem Austausch der beschädigten Objekte

Um diese Fragen automatisiert durch ein Computersystem beantworten zu lassen, bedarf es einer beispiellosen Einbindung von Expertenwissen in KI-Systeme. Gleichzeitig würde dies durch mehr Geschwindigkeit, Genauigkeit und Transparenz einen bedeutenden Vorteil für alle Beteiligten im Regulierungsprozess bedeuten.

Auf den ersten Blick bieten neuste Fortschritte im Bildverständnis durch „Convolutional Neural Networks (CNN)“ (dt. künstliche neuronale Netze) alle notwendigen Werkzeuge und Methoden, um eine KI-Black Box zu erstellen und zu trainieren. In der Praxis ist es aber kaum umsetzbar, solche Systeme End-to-End zu trainieren. Der Prozess ist schlichtweg zu komplex.

Um Computersystemen diese Komplexität durch Verwendung von modernster Deep-Learning-Technologie beizubringen, würde es eine riesige Menge an Trainingsdaten erfordern. Solche Datenmengen existieren momentan nicht und es wäre zu teuer, sie zu generieren. Darüber hinaus fehlt dem Black-Box-Ansatz eine wichtige Komponente: Die Begründung für die gemachten Vorhersagen. Das stellt ein erhebliches Problem für den Verhandlungsbestandteil des Regulierungsprozesses dar. Obwohl in vielen Fällen die pure Genauigkeit des KI-Systems den menschlichen Experten überlegen ist, sind die Vorhersagen in Verhandlungen nur schwerlich zu verwenden, weil die von Menschen gewohnte Argumentationsgrundlage fehlt.

Um dieses Hindernis zu umgehen, haben wir ein modulares Bildbewertungssystem entwickelt und trainiert, welches das Training von unabhängigen Modellen ermöglicht und einfach erweiterbar ist. Lassen Sie uns nun einen Blick auf die Hauptkomponenten unserer Methode werfen – zusammen mit aktuellen Möglichkeiten und Einschränkungen.

sach|eye – Ein bildverstehendes KI-System

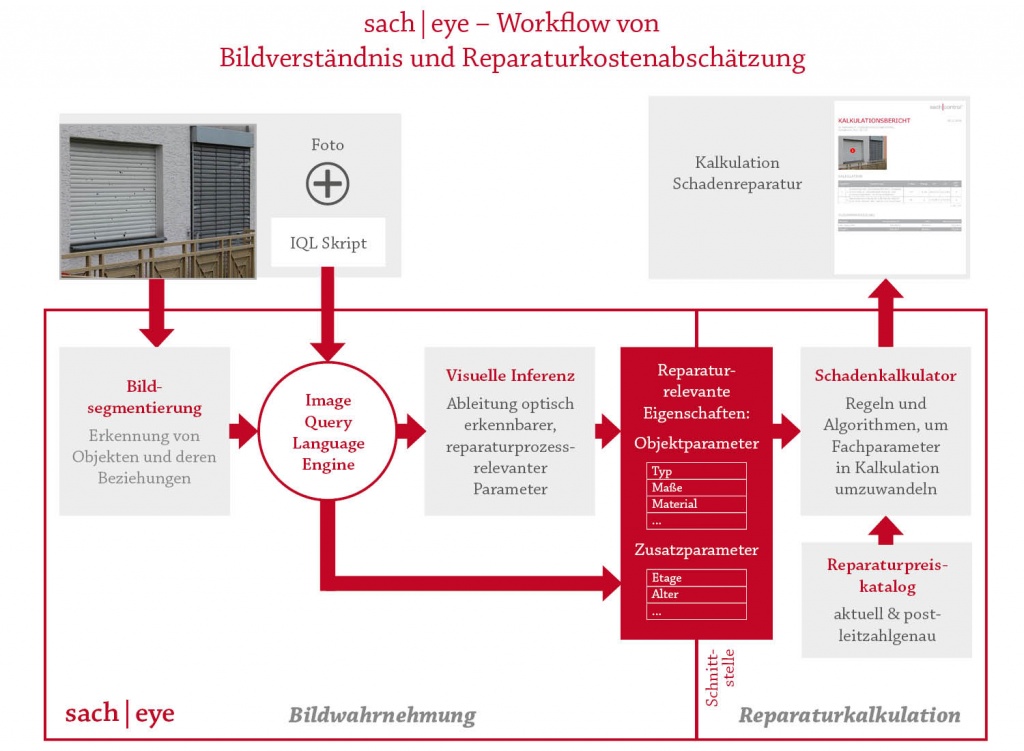

Auf der nachfolgenden Abbildung sehen Sie unser System sach|eye. Dieses wurde modular erstellt, um die benötigte Datenmenge bei der Erstellung von Bildverständnis- und Reparaturkalkulations-Algorithmen sowie deren Ergebnisse weniger interpretierbar zu machen. Zunächst haben wir die Aufgabe, Preise aus den Bildern zu erheben, in zwei komplett isolierte Abläufe getrennt: Die Bildwahrnehmung und die Algorithmen zur Kalkulation der Reparaturkosten.

Mit Hilfe von Bildsegmentierungsmodellen kann der Teil „Bildwahrnehmung“ das Bild verstehen. Außerdem extrahiert er aus dem Foto qualitative und quantitative Eigenschaften, die notwendig sind, um die Beschädigung einschätzen und die Reparatur kalkulieren zu können.

Die Kalkulation verwendet als Eingabe strukturierte Daten, die durch die Wahrnehmungsteile extrahiert werden. Dieser Teil des Systems ist für die Ableitung von Reparaturalgorithmen auf der Grundlage der Objekteigenschaften und unseres Reparaturpreiskatalogs verantwortlich. Es basiert auf den Regeln und der Reparaturlogik, die von menschlichen Bauexperten festgelegt werden.

Lassen Sie uns nun einen näheren Blick auf die Wahrnehmungsalgorithmen von sach|eye werfen.

Der Wahrnehmungsteil von sach|eye beinhaltet zwei Typen von Modellen. Der erste Typ basiert auf Bildsegmentierungsmethoden und ist hierarchisch aufgebaut. Seine Aufgabe ist es, relevante Objekte in den Bildern zu erkennen und hervorzuheben. Die Hierarchie des Modells ist nicht nur wichtig, um Beziehungen zwischen Objekten und ihren Teilen extrahieren zu können, sondern auch die Voraussetzung, dass die Objektauswahl in Bildern mithilfe der Image Query Language Engine (IQL) funktioniert. Zur Erfüllung seiner Aufgabe nutzt das Modell dazu die räumlichen Beziehungen zwischen Objekten auf verschiedenen Hierarchieebenen.

Modelle des zweiten Typs werden auf die Objekte angewendet, die durch die Segmentierungsmodelle im Originalbild bereits markiert wurden. Diese Modelle zielen darauf ab, die tatsächlichen Eigenschaften der erkannten Objekte vorherzusagen (z. B. Typ, Größe, Material usw.).

Bildsegmentierung

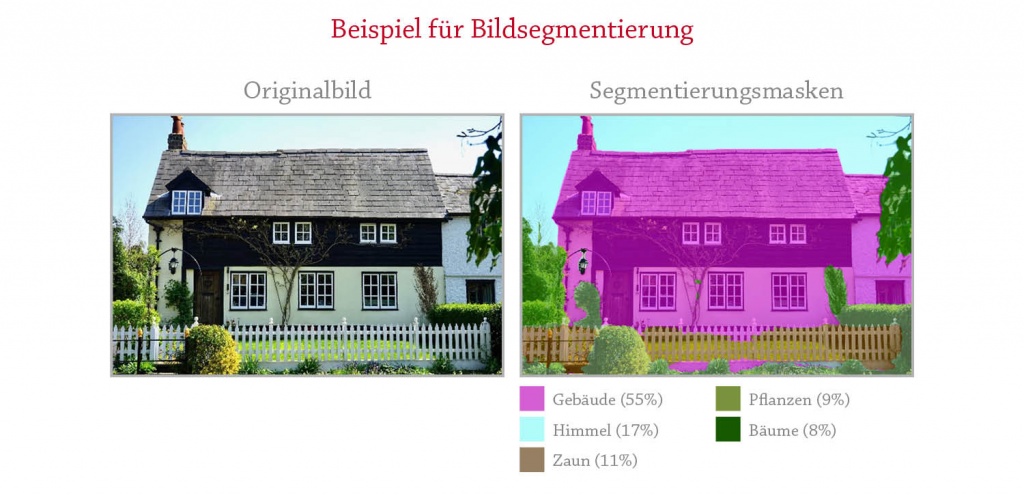

Die Bildsegmentierung klassifiziert das Bild auf Pixelebene. Dazu wird jedem Pixel eines eingehenden Bildes eine Kennzeichnung zugewiesen Ein Beispiel sehen Sie im nachfolgenden Bild.

Im Gegensatz zur Bildklassifizierung, bei der die Kennzeichnungen ganzen Bildern zugewiesen werden, bieten die Ergebnisse der Bildsegmentierung einen wesentlich tieferen Einblick in den Bildinhalt. So kann mit Hilfe von Segmentierungsmasken das Hauptobjekt erkennbar gemacht werden: Objekte, die einen größeren Bereich in dem Bild einnehmen, spielen wahrscheinlich eine wichtige Rolle in der fotografierten Szene. In unserem Beispiel wäre das das Haus. Objekte, die nur wenige Prozente des Bildes einnehmen, spielen häufig, aber nicht immer, eine untergeordnete Rolle.

Im Allgemeinen erfordert das Training eines beliebigen Bildsegmentierungsmodells – unabhängig von seiner internen Struktur – umfangreiche annotierte Daten auf Pixelebene. Von der Computer-Vision-Community wurden mehrere annotierte Bilddatensätze in verschiedener Qualität unter der Creative-Commons-Lizenz veröffentlicht, die auf verschiedensten Annotierungskonventionen beruhen. Diese Daten sind nach gründlicher Reinigung, Vorverarbeitung und Vereinheitlichung eine Grundlage, um unserem System das Verständnis allgemeiner Objekte wie Gebäude, Personen, Fahrzeuge usw. beizubringen. Obwohl die Vorverarbeitung verfügbarer Daten nach einem gemeinsamen Standard schwierig ist, ist die Erzeugung einer ausreichenden Menge an Trainingsdaten für neue, weniger verbreitete Objekttypen eine viel größere Herausforderung. Diese Herausforderung ist zweierlei.

Zunächst benötigt man genügend Bilder eines relevanten Objekts mit vielen Variationen des Objekts, Blickwinkels, Beleuchtung und der Kameraeigenschaften. Die Beschaffung solcher Bilder ist nicht unbedingt eine Herausforderung für Unternehmen, die mit Fotos in ihren bestehenden Gebäudeschadenprozessen umgehen müssen. Die Auswahl der richtigen Daten aus deren Gesamtheit ist weitaus schwieriger.

Zweitens müssen ausgewählte Bilder sowohl für neu hinzugefügte als auch für bereits vorhandene Objekte konsistent annotiert werden. Qualitativ hochwertige, dichte und konsistente Bildanmerkungen sind der Schlüssel zum Trainieren leistungsfähiger Segmentierungsmodelle. In der nachfolgenden Abbildung sehen Sie einige zufällig ausgewählte Beispiele für beschädigte Objekte (Rollläden, Flachdächer und Jalousien) sowie deren Anmerkungsmasken aus unserem Datenbestand.

Unsere Bilddatenbank besteht größtenteils aus realen Fotos von beschädigten Objekten in ihrem natürlichen Kontext. Diese Bilder sind sehr unterschiedlich und weichen stark ab in Qualität, Kameraeinstellungen und Lichtbedingungen.

Bildverständnis

Bildsegmentierungsmodelle sind zwar ein sehr differenzierter und aufschlussreicher Ansatz, aber im Vergleich zu dem für das Betreiben von Geschäftsanwendungen erforderlichen Bildverständnis doch recht vereinfacht.

Das tatsächliche Verstehen von Szenen, die durch Bilder dargestellt werden, bedeutet häufig das Verstehen von Beziehungen zwischen Objekten in Bildern. Der Hauptansatz für dieses Problem besteht darin, den Fotos Bildunterschriften zuzuordnen. Ähnlich wie es der Mensch machen würde.

Dazu trainiert man neuronale Netzwerke. Diese intelligenten Algorithmen mit beeindruckender Leistung können fast perfekt lernen, den Bildinhalt wie Menschen zu beschreiben. Dazu wandeln diese Methoden unstrukturierte Informationen aus Bildern in wiederum unstrukturierte, freie Textbeschriftungen um. Diese Untertitel können jedoch nur schwer als Input für nachgelagerte Geschäftsprozesse verwendet werden und müssen daher zunächst in eine strukturiertere Form umgewandelt werden. Unser Ansatz ist aber anders. Unsere angewendete Methode erstellt keine Textbeschriftungen aus Bildern, sondern extrahieren gleich strukturierte Informationen direkt aus diesen.

Bildsegmentierungsmodelle sind die Basis und der allererste Schritt dieser Extraktion. Moderne Bildsegmentierungsmodelle erstellen Architekturen, mit denen einzelne Bildpixel einzelnen Beschriftungen zugewiesen werden. Tatsächlich kann jedes Pixel und jedes Objekt (eine Gruppe verbundener Pixel mit derselben Kennzeichnung), das in dem Bild segmentiert ist, immer nur eine einzige Kennzeichnung erhalten.

Im Gegensatz zu dieser vereinfachten Behandlung funktioniert unsere menschliche Wahrnehmung und Interpretation von Bildern jedoch anders. So erkennen wir, dass Objekte gleichzeitig zu verschiedenen semantischen Kategorien gehören und verstehen, dass ein Teil des Bildes gleichzeitig zu einem anderen Teil des Bildes gehört.

Um diese wichtige Besonderheit des menschlichen Bildwahrnehmungsprozesses künstlich zu implementieren, trainieren wir mehrere Segmentierungsmodelle, die die Zuordnung des gleichen Pixels oder der gleichen Pixelgruppe in einem Bild zu verschiedenen Kennzeichnungen ermöglichen.

Im nachfolgendem Bild sehen Sie unsere derzeitige Implementierung, die drei Schichten von Segmentierungsmodellen umfasst: Allgemeines Szenenverständnis (E0), Objekterkennung (E1) und Schadensortung (E2)

Um die auf verschiedenen Ebenen erzeugten Segmentierungsergebnisse zu kombinieren und effizient zu verwenden, haben wir einen formalisierten Ansatz entwickelt und ihn „Image Query Language“ (IQL) genannt.

Image Query Language

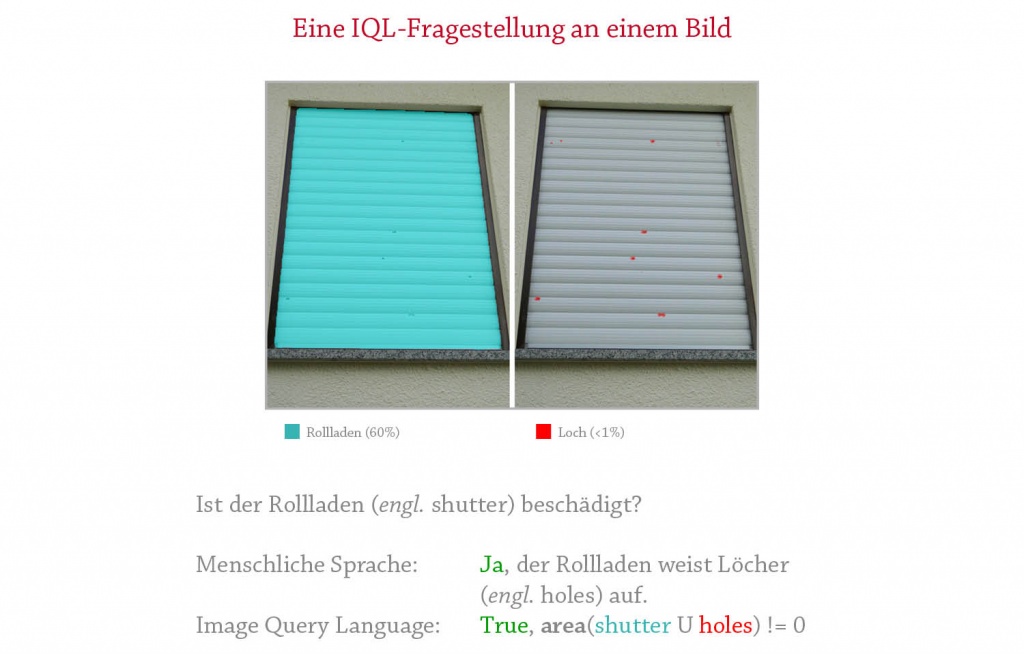

Die Idee der „Image Query Language“ entstand aus der Notwendigkeit, räumliche Beziehungen zwischen verschiedenen segmentierten Objekten in Bildern zu finden, um Fragestellungen zu beantworten, die an Bilder gestellt wurden.

Der Kern von IQL basiert auf „Boolean-Operationen“ (Or, And, Not, Xor), die auf jedes Objekt angewendet werden können, die von den Segmentierungsmodellen erkannt werden. IQL umfasst auch andere mathematische Hilfsfunktionen (z. B. Fläche, Anzahl usw.) sowie räumliche Beziehungsfunktionen (z. B. in der Nähe, nicht in der Nähe, interagieren usw.) die als zusätzliche Einschränkungen für geometrische 2D-Formen verwendet werden können. In der nachfolgenden Abbildung sehen Sie ein Beispiel für dieselbe Frage an ein Bild in menschlicher Sprache und unter Verwendung der IQL-Sprachform.

Die IQL-Engine arbeitet mit der Standardausgabe der Bildsegmentierungsmodelle und kann optional in dem Moment aufgerufen werden, wenn ein Bild an sach|eye übergeben wird. Prinzipiell ist IQL eine Sprache, die ein externer Benutzer verwenden kann, um bestimmte Objekte in einem Bild nach bestimmten Kriterien erkennen lassen kann. Dieser Ansatz bietet Anwendern eine beispiellose Flexibilität, indem sie ermöglicht, dass nahezu beliebige Kombinationen von vordefinierten physischen Objekten, die den Segmentierungsmodellen bekannt sind, für den Feinauswahlprozess verwendet werden. Tatsächlich entkoppelt IQL die auf die Ergebnisse der Bildsegmentierung angewendete Geschäftslogik vom Prozess der Bildsegmentierung selbst.

Visuelle Schlussfolgerung (Visual Inference)

Sobald Objekte von Interesse durch Segmentierungsmodelle herausgeschnitten und mithilfe der IQL-Engine ausgewählt wurden, werden sie an das Visual Inference-Modul gesendet, wo wichtige Objektparameter abgeleitet werden. Diese Parameter wurden von Experten mit Kenntnissen für die Reparaturkalkulation festgelegt. Abhängig von einem bestimmten Objekt können diese Parameter Material, Oberflächentyp, Montagemethode, Farbe, Objektabmessungen usw. umfassen.

Trainingsmodelle zum Vorhersagen von qualitativen Parametern wie Material, Profilform usw. erfordern moderate annotierte Datenmengen (1.000-10.000 Trainingsbeispiele), um übermenschliche Genauigkeiten bei der Klassifizierung zu erreichen. Diese Datenmenge kann in den meisten Fällen in der realen Welt erfasst werden. In unserem Testdatensatz für das Modell zur Klassifizierung von Rollladenmaterials zwischen Kunststoff und Aluminium wurde mit dieser Menge annotierter Daten eine Genauigkeit von 84,6% erreicht.

Das Erstellen von Modellen zur Vorhersage der tatsächlichen absoluten Abmessungen von beliebig fotografierten Objekten ist eine Herausforderung. In der Tat komprimiert der Prozess des Fotografierens Informationen der 3D-Welt auf zwei Dimensionen eines ebenen Bildes. Entscheidend ist dabei, dass die Entfernung zu fotografierten Objekten von Standardkameras nicht aufgezeichnet werden. Das macht es unmöglich, Entfernungen in der Bildebene auf reale Dimensionen abzubilden. Unter der Annahme, dass keine Tiefeninformationen verfügbar sind, besteht die einzige verfügbare Option, diese Zuordnung zu ermöglichen, in der Verwendung einiger Referenzen in dem Bild selbst.

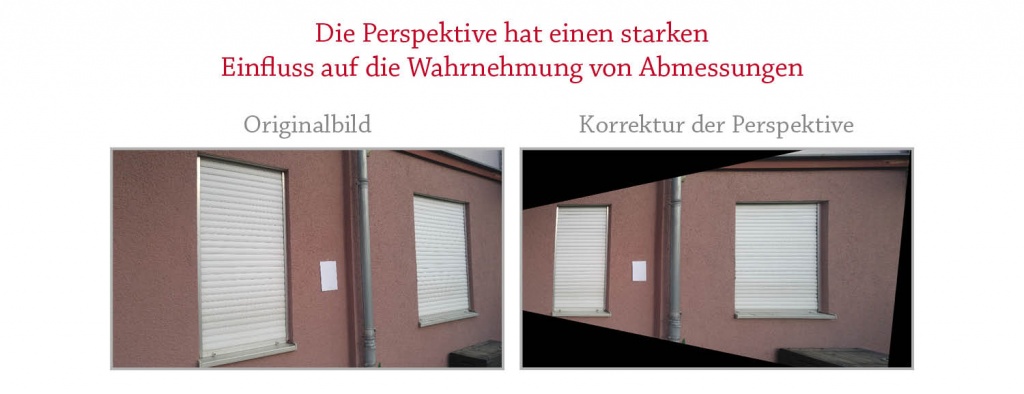

Wir verwenden tiefe „Convolutional Neural Networks (CNN)“ (dt. künstliche neuronale Netze), um diese Referenzen zu erlernen. Dazu werden von Experten angereicherte, objektbezogene Dimensionsdaten verwendet. Dieser Ansatz funktioniert überraschend gut für Objekte mit eindeutigen, charakteristischen und optisch erkennbaren Merkmalen bei der seitlichen Ansicht des Objekts und bietet optimale Leistung bei Frontansicht-Bildern (aus Winkeln nahe an der Oberfläche des Objekts). Schrägansichten von Bildern erschweren die korrekte Schätzung der absoluten Abmessungen von seitlich verzerrten Objekten in Bildern – sowohl für menschliche Experten als auch für Computersichtsysteme.

In der nachfolgenden Abbildung ist zu sehen, dass das Fenster 1 im Originalfoto scheinbar eine ähnliche Größe (wenn nicht sogar größer) hat wie Fenster 2. Nach der Perspektivenkorrektur sieht man jedoch nun, dass das Fenster 2 in Wirklichkeit 50% breiter als das Fenster 1 ist.

Die perspektivische Korrektur in dem Beispiel ist eine triviale Aufgabe, wenn sich zweidimensionale Referenzobjekte in derselben Ebene befinden wie die relevanten Objekte (in diesem Fall die Fensteroberfläche). Im obigen Beispiel wird die A4-Seite als Referenz verwendet, um eine Perspektivenkorrektur durchzuführen und korrigierte Bildpixelabmessungen im realen Maßstab abzubilden.

Die Verwendung der A4-Seite als Referenz ermöglicht das Messen von Oberflächenbereichen bei ebenen Objekten in Bildern mit einem relativen Fehler von mehr als 10% bei typischen Bedingungen beim Fotografieren beschädigter Fenster und Fassaden.

Wenn sich in einem Bild kein vordefiniertes Referenzobjekt befindet, können – aufgrund eines irreversiblen Informationsverlusts – streng genommen keine absoluten Objektmaße ausgelesen werden. Andererseits können Fachexperten auf Grundlage der in Bildern verfügbaren indirekten Verweise sowie ihrer Kenntnis zu Größenbeschränkungen und möglicher Größenoptionen vernünftige Schätzungen zu Objektgrößen und -bereichen vornehmen.

Um diesen Schätzprozess nachzuahmen, trainieren wir „CNN“-basierte Modelle, die ein Bild eines bestimmten vordefinierten Objekts als Eingabe nehmen und die seitlichen Abmessungen und/oder Fläche des Objektes ableiten. Das beste von uns gebaute Modell weist für die Flächenvorhersage bei Rollläden einen relativen Fehler von 24,5% auf. Dieser wird als Durchschnitt der relativen absoluten Abweichung der annotierten und vorhergesagten Rollladenflächen über den gesamten Testsatz berechnet. Nach mehreren Versuchen zur Verbesserung der Modellleistung haben wir festgestellt, dass die Genauigkeit der Daten begrenzt ist. Mit anderen Worten, menschliche Experten sind nicht immer in der Lage, Objektabmessungen in Bildern zuverlässig und reproduzierbar zu annotieren.

Um diese Hypothese zu bestätigen, haben wir drei Fachexperten gebeten, Bereiche derselben Rollläden in unserem Test-Set zu annotieren. Dabei haben wir eine durchschnittliche Abweichung von Experte zu Experte von 33,5% festgestellt, was bedeutet, dass das Modell die Streuung der Expertenmeinung um fast 10% übertrifft.

Bei der Analyse von Annotationen verschiedener Experten stellten wir fest, dass die Streuung der Expertenmeinung mit den Aufnahmebedingungen des Bildes miteinander in Verbindung steht. Frontale Aufnahmen haben eine geringere Abweichung, wohingegen Bilder, die aus schrägen Winkeln aufgenommen wurden und eine ausgeprägte Perspektivverzerrung haben, zu einer stärkeren Variation der Beurteilung von Experten führen.

Zusammenfassung

sach|eye ist das bildverstehende KI-System, das auf einer Kombination von Computer-Vision- und Machine-Learning-Algorithmen sowie Expertenwissen im Bereich der Sachversicherung und der Gebäudereparatur basiert.

Es ist ein modulares System, bei dem die Bildwahrnehmung und die automatische Schadenkalkulation mithilfe eines Vektors von reparaturrelevanten Parametern vollständig entkoppelt sind. Mit „Image Query Language“ können Benutzer die Bildwahrnehmung zur Feinabstimmung der gewünschten Ausgabe programmieren.

Derzeit werden visuelle Schlussfolgerungen und automatisierte Reparaturkalkulationen für Bilder von Rollläden, Jalousien und Flachdächern unterstützt. Sowohl Experten als auch sach|eye haben eine wesentlich geringere Genauigkeit der Einschätzung von Größen in Bildern, in denen Objekte aus schrägen Winkeln aufgenommen wurden. Das Platzieren von einfachen, vordefinierten Referenzobjekten in Schadensfotos verbessert die Genauigkeit dieser Schätzung um das 3-fache für das Rollladengehäuse.

Über den Autor

Der promovierte Data Scientist ist seit 2017 als Datenflüsterer bei sachcontrol unterwegs. Unstrukturierte Daten werden von ihm geschickt entschlüsselt, verknüpft und analysiert, um wertvolle Informationen aus dem Datenmeer zu extrahieren. In seiner Freizeit trainiert er seinen Geist gern bei einer Partie Schach oder schmökert in einem guten Buch.